Contemplum

La palabra contemplar deriva del vocablo latino contemplum. Así se denominaba a una plataforma elevada que solía estar en los templos paganos. Se la utilizaba para estudiar el firmamento por las noches y descubrir desde allí los designios de los dioses. Lo que iba a suceder. De contemplum procede el término contemplari que significa “mirar lejos”.

Contemplar es mirar, pero con atención. ¡Con interés! Y ese interés proviene del valor que tiene lo observado. Hay distintas maneras de llevar adelante esta observación para extraer lo deseado. Es decir: el cómo observamos define lo que obtenemos.

Se dice en las empresas, se repite de manera hueca, que los datos aportan valor. Pero poco se estudia cómo extraerlo. El valor de los datos no está dado por los datos en sí, sino por las técnicas de análisis que se aplican sobre ellos.

Cada técnica genera un tipo de valor diferente.

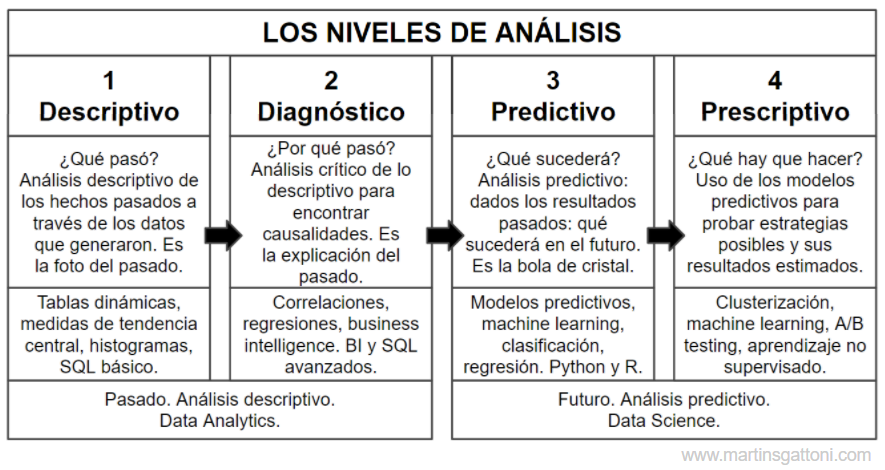

En Data Science se definen dos métodos de contemplación que sirven para extraer resultados diferentes: el Análisis Descriptivo y el Análisis Predictivo. Ambos, además, se dividen en 2 subniveles.

Mirando hacia atrás: el Análisis Descriptivo

Hay un atributo que tienen los datos que es incuestionable: son propiedad del pasado. Cuando hago Análisis Descriptivo me paro en el presente, me doy vuelta hacia atrás y describo lo que sucedió.

El valor a obtener en este nivel surge de responder la pregunta: ¿Qué pasó?

Así, la mayoría de los reportes que consultamos en nuestro BI son de naturaleza descriptiva:

- Histórico de ventas mensuales del último año.

- Usuarios que hicieron reclamos en los últimos 90 días.

- Clientes que compraron por encima de la media en su último pedido.

Las herramientas clásicas de Data Science para hacer Análisis Descriptivo son: las tablas dinámicas en Excel, las medidas de tendencia central, los histogramas, el SQL básico.

Si a esa descripción histórica de lo que veo en los datos le agrego técnicas de exploración que encuentren los motivos de lo sucedido, estaré haciendo también Análisis Diagnóstico.

El valor a obtener en este nivel surge de responder la pregunta: ¿Por qué pasó?

Algunos ejemplos de reportes de diagnóstico son:

- Histórico de mis ventas en relación a la evolución del mercado total.

- Correlación entre variables de la economía y mi demanda.

- Evolución de la demanda ante variaciones de los precios.

Las herramientas clásicas de Ciencia de Datos para hacer Análisis Diagnóstico son: las correlaciones, las regresiones y el SQL avanzado.

¿Qué es predecir?

El Análisis Predictivo no es adivinar el futuro, es una forma de contemplación diferente. Aclaremos una obviedad: este tipo de análisis se hace también sobre la misma fuente: los datos del pasado. No tenemos información del futuro para predecir (salvo que seamos clarividentes). La materia prima es la misma.

Entonces cuando hablamos de Análisis Predictivo nos referimos a una serie de técnicas de análisis en particular. A diferencia de los niveles ya descritos, donde el objetivo es obtener una representación de lo que pasó, en los niveles predictivos buscamos crear los escenarios futuros más probables en base al análisis histórico de lo sucedido.

Los resultados de los modelos predictivos estarán siempre asociados a una probabilidad de ocurrencia que tiene que ver con la certeza que el modelo asume sobre sí mismo. No profundizaré sobre este tema hoy, pero sí diré que las técnicas predictivas son capaces de evaluarse a sí mismas y dar un grado de veracidad a sus resultados.

Aquí es clave entender esta idea de probabilidad asociada al resultado. Por lo general, cuando implemento modelos de este tipo con mis clientes, les cuesta mucho entender los resultados en términos de probabilidad y hacen un mal uso de la herramienta. El problema es que estamos acostumbrados a entender a los datos de manera determinista (descriptiva).

Tratemos de clarificar esta idea con un ejemplo. Le propongo que piense: hay un modelo predictivo que la mayoría de las personas consume a diario. Adivine ¿se le ocurre cuál es?

Sí, el pronóstico del clima. Este es un claro ejemplo de Análisis Predictivo con el que estamos familiarizados. Observe que cumple con todo lo que dije recién: es un modo de análisis de datos provenientes del pasado que trata de estimar el escenario futuro más probable.

Observe que la idea de una probabilidad asociada a cada resultado aquí se hace evidente: ¿qué quiere decir que mañana hay una posibilidad de lluvias del 60%? Bueno, simplificando el tema, el 60% es nuestro indicador de probabilidad sobre nuestro resultado más probable, la lluvia. Y se interpreta de la siguiente manera: el modelo lo que está diciendo es que en el análisis histórico de los datos, ante las mismas condiciones climáticas (temperatura, humedad, viento, presión, etc), llovió en el 60% de los días.

La probabilidad de ocurrencia no existe en el Análisis Descriptivo porque los resultados son deterministas: ya sucedieron. En el Predictivo, en cambio, hay incertidumbre. Los eventos nunca se repiten de igual manera. Además, nuestros datos son siempre insuficientes, no tenemos relevada la totalidad de la información. Tenemos que adivinar con retazos. En mis clases me gusta explicar esto con el Demonio de Laplace.

“Podemos mirar el estado presente del universo como el efecto del pasado y la causa de su futuro. Se podría concebir un intelecto que en cualquier momento dado conociera todas las fuerzas que animan la naturaleza y las posiciones de los seres que la componen; si este intelecto fuera lo suficientemente vasto como para someter los datos a análisis, podría condensar en una simple fórmula el movimiento de los grandes cuerpos del universo y del átomo más ligero; para tal intelecto nada podría ser incierto y el futuro, así como el pasado, estarían frente a sus ojos.“

Pierre-Simon Laplace

Pierre-Simon Laplace fue un astrónomo y filósofo francés. Él postulaba que el fin supremo de la ciencia era predecir todo mediante el entendimiento de las causas y sus efectos. Su pensamiento era determinista: suponía que si existiera un demonio capaz de conocer de antemano todas propiedades de todas las partículas del universo, ese ser sería capaz de predecir el futuro a la perfección.

La mirada determinista de Laplace es fundamental porque se basa en un supuesto con el que necesariamente debemos estar de acuerdo en Data Science: cuanta más información tenga, mejor podré estimar lo que va a suceder.

Mirando hacia adelante: el Análisis Predictivo

Entonces incluiremos dentro del Análisis Predictivo al conjunto de técnicas estadísticas y de Machine Learning que generan modelos predictivos en base a la detección de patrones en los datos del pasado.

El valor a obtener en este nivel surge de responder la pregunta: ¿Qué sucederá?

Algunas de estas técnicas son:

- Pronósticos con series temporales para estimar la evolución futura de demanda, rotación, cadena de suministros.

- Modelos de segmentación de riesgo (churn risk) para detectar a los clientes que requieren atención especial.

- Modelos de clasificación o regresión para automatizar procesos de categorización como: aprobación de viáticos, detección de actividad fraudulenta, segmentación de nuevos clientes.

Las herramientas de Ciencia de Datos para hacer Análisis Predictivo son: modelos predictivos, Machine Learning, clasificación, regresión, Python y R.

Pero esto no termina acá. También podemos dotar a los modelos predictivos de capacidades de dirección. En este caso a este último nivel lo llamamos Análisis Prescriptivo. Constituye aquellos modelos que, además de predecir, nos sugieren qué debemos hacer ante ese probable escenario que se aproxima.

El valor a obtener en este nivel surge de responder la pregunta: ¿Qué hay que hacer?

Algunas técnicas prescriptivas son:

- Acciones promocionales de tipo A/B Testing para determinar las acciones más eficientes a aplicar.

- Construcción de combos de cross-selling o up-selling en base al uso de modelos de Basket analytics.

- Detección de clusters por riesgo y valor para accionar de manera discriminada sobre cada segmento de clientes.

Las herramientas de Ciencia de Datos para hacer Análisis Prescriptivo son: segmentación escalar, Machine Learning, A/B testing, aprendizaje no supervisado.

Un caso real

Bajemos estos conceptos a la realidad y específicamente al rubro del marketing que es el que nos interesa: hace unos meses implementamos nuestra herramienta Florensys.com para una farmacéutica multinacional en Argentina. El objetivo era dotar a su programa de fidelización de pacientes de una “inteligencia de datos” superior a la que tenían, que era bastante elemental.

Florensys es una herramienta de nuestra autoría que automatiza y centraliza varios de los modelos predictivos para marketing que ya mencioné:

- Aplicamos un modelo de segmentación clásico RFM para hacer un Análisis Descriptivo inicial del target de pacientes.

- Hicimos reportes de correlación y evolutivos de las distintas variables para el Análisis Diagnóstico que nos permitió detectar algunos problemas en la ejecución del programa.

- Creamos un Modelo de Riesgo que analizó los patrones de consumo de cada paciente y los segmentó por nivel de tendencia al abandono.

- Con los resultados de la segmentación y el Modelo de Riesgo se armó un programa de Marketing Automation a medida de cada paciente.

- Con estos modelos y sus resultados se formatearon y crearon piezas de comunicación a medida de cada segmento. Por ejemplo: se reforzaron las comunicaciones basadas en la importancia de la continuidad del tratamiento a los clusters con baja adherencia.

- Se determinaron frecuencias de contacto individuales según el riesgo de abandono de cada paciente. ¿¡Por qué molestar con mensajes a quién no está en riesgo!?

- Se reformuló el mix de canales para cada paciente en base a su CLTV: se usarán los canales más costosos para los pacientes con mayor valor a futuro.

Este tipo de análisis se implementa sobre cualquier tipo de target. En nuestro caso lo hemos aplicado también a target de médicos (en base a las auditorías prescriptivas) y a target de farmacias (en base a sus transfers). Y sirve para cualquier rubro: actualmente estamos haciendo una experiencia piloto con una importante cadena de gimnasios. Funciona muy bien también en e-commerce.

Resumiendo: tener en claro los Niveles de Análisis (Descriptivo, Diagnóstico, Predictivo, Prescriptivo) es una primera manera de entender todo el valor que ocultan nuestros datos. El siguiente paso es definir la estrategia.

Lic. Martín Marcelo Sgattoni

www.idealsur.com